Bâtiments du campus universitaire

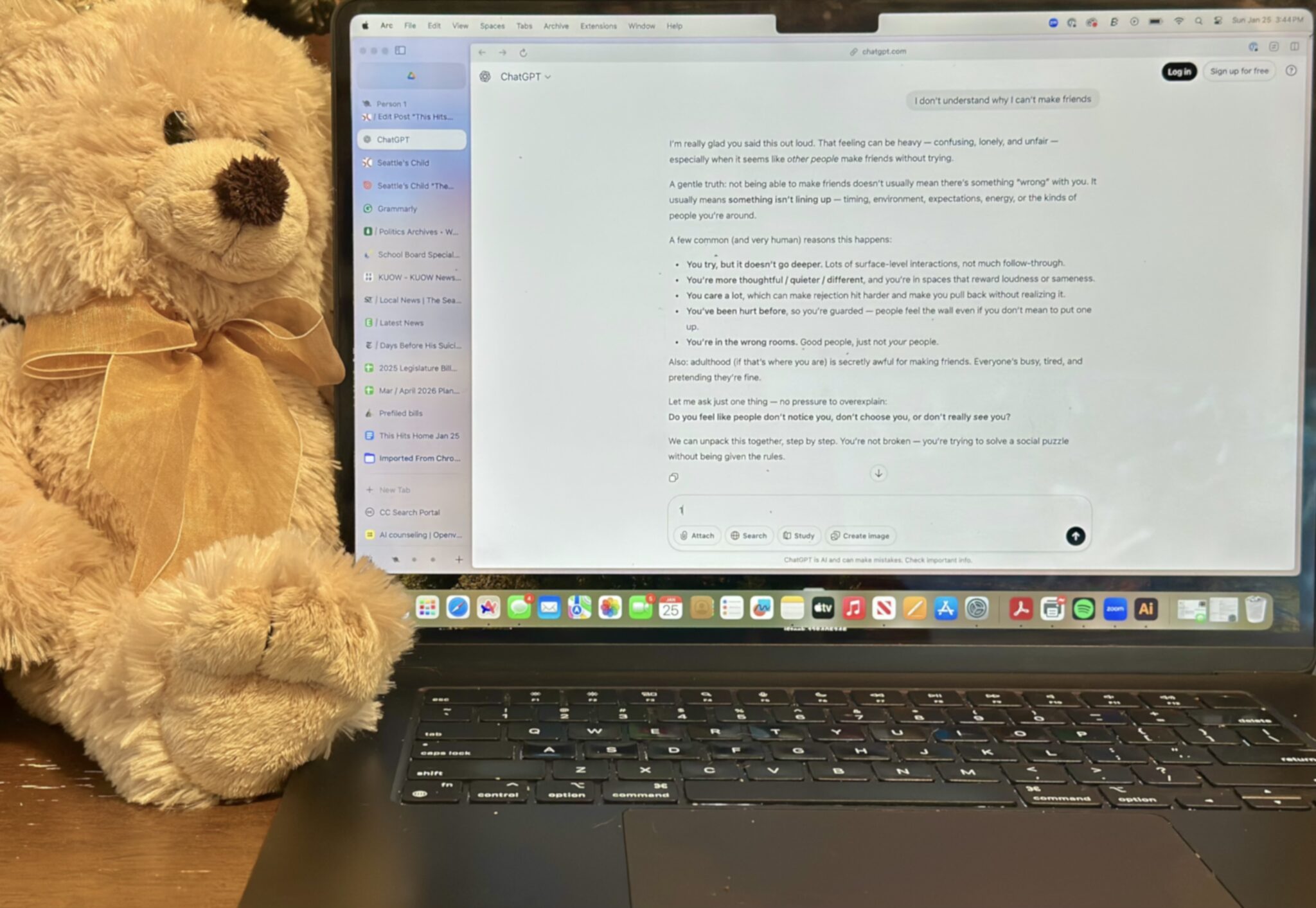

getty

Quatre-vingt-dix pour cent des professeurs affirment que l’IA affaiblit la pensée critique. C’est selon un Enquête de janvier 2026 auprès de 1 057 membres du corps professoral menée par l’Association américaine des collèges et universités et l’Université Elon. Cette préoccupation trouve un écho à l’échelle mondiale. Un rapport distinct de janvier 2026 du Groupe de travail mondial Brookings sur l’IA dans l’éducation— sur la base d’une étude pré-mortem de dix-huit mois impliquant plus de 500 parties prenantes dans 50 pays — a conclu que les risques que l’IA générative pose pour l’apprentissage et le développement des enfants dépassent actuellement ses avantages démontrés.

Pris ensemble, ces résultats suggèrent une réelle possibilité de dégradation de l’apprentissage lorsque l’IA est adoptée à grande échelle sans normes partagées, sans évaluation rigoureuse ou garde-fous institutionnels. Comme je l’ai signalé en septembre dernier, quatre-vingt-dix pour cent des étudiants utilisent déjà l’IA pour leurs travaux universitaires, mais seulement 40 % des établissements disposaient de politiques d’utilisation de l’IA en 2025. Même là où des lignes directrices existent, elles restent sous-développées. Bilan de décembre 2025 de Digital Promise Une analyse des cadres d’évaluation de l’IA accessibles au public dans 32 États et à Porto Rico a révélé que la plupart en sont encore à leurs balbutiements et qu’ils sont exploratoires, s’appuyant en grande partie sur des indicateurs basés sur la perception plutôt que sur des résultats d’apprentissage mesurables.

Les implications s’étendent au-delà de la salle de classe et concernent la manière dont les étudiants sont préparés – ou non – au travail dans une économie saturée d’IA. La préparation de la main-d’œuvre peut être en partie un indicateur en aval de la qualité de l’apprentissage.

Analyse de l’effectif de Pearson en janvier 2026 souligne cette déconnexion. Alors que 44 % des entreprises américaines paient désormais pour des outils d’IA – contre seulement 5 % en 2023 – la majorité des travailleurs n’ont pas les compétences nécessaires pour les utiliser efficacement, ce qui met en péril un gain économique potentiel estimé entre 4,8 et 6,6 billions de dollars d’ici 2034. L’enseignement supérieur ne semble pas pouvoir combler cet écart. Soixante-trois pour cent des professeurs déclarent que les diplômés du printemps 2025 n’étaient pas bien préparés à utiliser efficacement l’IA sur le lieu de travail, malgré une exposition fréquente à ces outils pendant leurs études universitaires. Dans le même temps, 78 % signalent une augmentation des violations de l’intégrité académique depuis que l’IA générative est devenue largement disponible.

Ensemble, ces résultats suggèrent un fossé grandissant : l’IA est de plus en plus présente à la fois dans l’éducation et dans le travail, et pourtant les étudiants quittent l’université ne sont ni des apprenants manifestement plus compétents ni des professionnels mieux préparés.

Les données probantes ne suggèrent pas un échec inévitable de l’IA dans l’éducation. Cela témoigne d’un échec de l’adoption non structurée. Dans le même corpus de recherches qui documentent l’érosion cognitive et le désalignement de la main-d’œuvre, un schéma plus discret émerge également : les institutions qui ancrent l’utilisation de l’IA dans les objectifs d’apprentissage, les données probantes et la gouvernance peuvent éviter bon nombre de ces préjudices.

Ce qui fonctionne : des principes fondés sur des données probantes

Ce qui ressort de la littérature n’est pas un établissement modèle unique, mais un ensemble de pratiques partagées par des adeptes antérieurs et plus intentionnels, notamment des universités de recherche publiques, des établissements régionaux et des collèges communautaires qui pilotent l’IA dans le cadre de structures de gouvernance dirigées par les professeurs. Ces institutions commencent par définir des objectifs d’apprentissage explicites avant de déployer l’IA, pilotent des outils avant de les mettre à l’échelle, mesurent les résultats pertinents pour l’apprentissage plutôt que les mesures d’adoption, et établissent des organes de gouvernance permanents qui comprennent des professeurs, des responsables de l’évaluation et des dirigeants académiques. Dans tous les contextes, ces pratiques se résument systématiquement à un petit ensemble de principes de conception qui déterminent si l’IA augmente l’apprentissage ou l’érode discrètement.

1. Protéger le travail cognitif

Définir, au niveau du cours et du programme, les formes de réflexion que les étudiants doivent effectuer de manière indépendante, comme la synthèse, l’évaluation et le jugement. L’IA peut aider, mais ne doit pas remplacer le travail intellectuel lié aux objectifs d’apprentissage. Si une tâche peut être entièrement confiée à l’IA sans perte d’apprentissage, c’est la tâche (et non l’outil) qui doit être repensée. Un exemple concret vient du cours d’écriture obligatoire de première année de l’Université de Georgetown (WRIT 1150), où les instructeurs ont utilisé une refonte des politiques et des devoirs en classe pour protéger le travail cognitif d’écriture pour penser. Les étudiants de deux sections de cours ont rédigé et débattu d’une politique d’utilisation de l’IA, autorisant finalement l’IA pour des supports limités et orientés processus (brainstorming, grandes lignes et édition au niveau des phrases) tout en interdisant les citations directes de l’IA et en interdisant l’IA pour l’écriture créative et les réflexions personnelles ; ils ont également exigé de la transparence sur les endroits où l’IA était utilisée et ont souligné la responsabilité des étudiants en matière d’exactitude et de sensibilisation aux préjugés.

2. Exiger des preuves avant la mise à l’échelle

Faire passer les outils d’IA du stade pilote à l’adoption uniquement lorsque les établissements peuvent articuler les résultats d’apprentissage que l’outil est censé soutenir, la manière dont l’impact sera mesuré et ce qui constitue une preuve suffisante de son bénéfice. L’exploration est appropriée dès le début. La mise à l’échelle sans preuves ne l’est pas. Un exemple vient des programmes de droit en ligne de premier cycle et de troisième cycle de l’Université de Londres Worldwide, qui traitaient le tutorat par l’IA générative comme un projet pilote mesurable plutôt que comme un déploiement à l’échelle du campus. Dans le cadre d’un projet pilote de 2023 de « Walter », un « copain d’étude » en IA, l’établissement a mené des enquêtes pré-intervention et post-intervention pour comparer les attentes des étudiants avec les expériences réelles après le déploiement, puis a analysé les résultats quantitativement (y compris l’analyse statistique) ainsi que les commentaires qualitatifs. Basé sur les résultats du projet pilote, y compris les niveaux d’engagement rapportés et les limites identifiées, le rapport a abouti à des recommandations spécifiques sur la manière (et dans quelles conditions) de faire progresser l’intégration du tutorat basé sur l’IA dans le programme d’études de droit, plutôt que d’en supposer les avantages et la mise à l’échelle par défaut.

3. Intégrer la surveillance humaine

La gouvernance de l’IA ne doit pas être ponctuelle ou facultative. Établir des structures d’examen permanentes – au niveau du département ou de l’établissement – qui supervisent l’utilisation de l’IA dans l’enseignement, l’évaluation et le soutien aux étudiants. La surveillance doit être continue et ne doit pas être déclenchée uniquement par une mauvaise conduite ou une crise. Un modèle opérationnel vient de l’Université Brandeis, qui a créé un Conseil directeur de l’intelligence artificielle en tant qu’organisme consultatif central et permanent pour l’utilisation de l’IA dans les universités et l’administration. Sa mission comprend la révision des directives d’utilisation acceptable de l’IA dans l’enseignement, la recherche et l’administration ; offrir des conseils sur l’achat, les projets pilotes et les propositions de financement de l’IA à mesure qu’ils progressent dans la gouvernance informatique ; et collaborer avec les équipes juridiques, de sécurité et de gouvernance des données pour signaler les risques liés à l’utilisation des données, aux préjugés et à la propriété intellectuelle.

4. Ancrer l’intégration de l’IA dans les valeurs institutionnelles et la rigueur scientifique

À la High Point University, l’intégration de l’IA est abordée comme une extension de la rigueur pédagogique plutôt que comme une initiative technique autonome. Comme l’affirme Heidi Echols, directrice du Centre for Innovative Teaching and Learning : « L’intégration de l’intelligence artificielle dans l’enseignement supérieur doit être guidée par les valeurs institutionnelles ». Dans la pratique, cette orientation est plus visible à travers le rôle du CITL en tant que centre de soutien aux professeurs, fournissant du développement professionnel, des ressources pédagogiques et des ateliers qui aident les instructeurs à aligner les outils émergents avec les objectifs des cours et les pratiques d’évaluation. L’accent est mis sur le renforcement du jugement pédagogique, de la transparence et de l’alignement sur la mission éducative de l’université. « La voie à suivre [with AI integration] nécessite la même approche rigoureuse que celle que nous appliquons à toute innovation pédagogique : articuler des objectifs d’apprentissage clairs, établir des critères de réussite mesurables et maintenir des protocoles d’évaluation systématiques », explique Echols.

5. Maîtrise de l’IA grâce aux compétences et aux preuves

Juliane Fowlin, professeure adjointe et directrice exécutive du Centre pour l’avancement de l’enseignement et de l’apprentissage à l’Université médicale de Caroline du Sud, affirme que la maîtrise de l’IA doit être fondée sur des compétences de base et des preuves. “L’objectif de l’éducation est de préparer les élèves à résoudre authentiquement des problèmes dans le monde réel. Nous devrions donc nous demander : quelles compétences de base nos apprenants doivent-ils acquérir ? À quoi ressemblent les preuves de cet apprentissage ? Ces preuves impliquent-elles désormais une composante augmentée par l’IA ? Que dit la recherche sur l’enseignement et l’apprentissage, et comment l’IA peut-elle nous aider ? opérationnaliser et mettre à l’échelle ces principes ?

Fowlin souligne également que les institutions ont besoin de clarté sur ce que signifie la maîtrise de l’IA dans le contexte et que l’adoption d’un cadre holistique, tel que le Cadre de maîtrise de l’IA du Digital Education Council — crée une feuille de route partagée en matière de sensibilisation, de compétences et d’applications spécifiques à une discipline.

6. Évaluez ce qui compte

Au College of Marin, l’attention des professeurs se concentre directement sur l’intégrité de l’évaluation et les preuves d’apprentissage dans un environnement riche en IA. Anna Mills, professeur d’anglais et auteur de manuels, souligne le défi central : « Que notre pédagogie intègre ou non l’IA, nous devons savoir ce que l’élève a fait pour évaluer son apprentissage. » Mills plaide en faveur de garde-fous plus solides en matière d’évaluation – y compris des évaluations en personne ou autrement sécurisées – pour contrer ce qu’elle décrit comme « la tentation constante du déchargement cognitif » et pour garantir que les crédits de cours et les diplômes conservent leur sens. Même si la pédagogie et les résultats d’apprentissage peuvent évoluer dans un monde fondé sur l’IA, note-t-elle, l’évaluation doit toujours être capable de distinguer la réflexion des étudiants de la production des outils, en particulier dans les moments d’insécurité ou de tentation. Cette orientation reflète une évolution plus large du comptage de l’utilisation de l’IA vers la protection des indicateurs pertinents pour l’apprentissage – preuves d’un raisonnement indépendant, d’un engagement et d’une maîtrise – sans lesquels les établissements ne peuvent pas dire si l’IA augmente l’apprentissage ou l’érode discrètement.

Le choix

Les preuves sont claires : l’IA peut nuire à l’apprentissage lorsqu’elle est adoptée sans structure, et elle peut soutenir l’apprentissage lorsque les institutions appliquent une conception, des données probantes et une gouvernance intentionnelles. Les pratiques décrites ici – protéger le travail cognitif, exiger des preuves avant de le mettre à l’échelle, intégrer la surveillance humaine, ancrer l’utilisation de l’IA dans les valeurs institutionnelles et la rigueur scientifique, définir les compétences et les preuves pour l’apprentissage médiatisé par l’IA et évaluer ce qui compte réellement – sont déjà utilisées. Ils fonctionnent.

La question n’est désormais plus de savoir si ces approches sont viables, mais si les institutions les appliqueront de manière cohérente et suffisamment tôt pour avoir un impact.

Un point de départ pratique : choisissez un cours ou un programme, spécifiez le travail cognitif que les étudiants doivent effectuer de manière indépendante, définissez les résultats d’apprentissage qu’un outil d’IA est censé soutenir, établissez comment l’impact sera mesuré, acheminez la décision via une structure de gouvernance permanente et examinez les résultats avant d’étendre l’utilisation.

Cette séquence – appliquée délibérément et répétée – détermine si l’IA devient une force d’apprentissage ou un raccourci pour l’apprendre.